引言

在人工智能与自然语言处理的浩瀚星空中,Transformer模型犹如一颗璀璨的明星,以其强大的并行处理能力和卓越的性能,引领着深度学习的新纪元。本文将带你深入Transformer的内部世界,从理论到实践,一步步“手撕”这一复杂而精妙的架构。

一、Transformer基础概览

Transformer模型由Vaswani等人于2017年提出,旨在解决序列到序列(Seq2Seq)任务中的长期依赖问题。与传统的循环神经网络(RNN)和长短时记忆网络(LSTM)不同,Transformer完全基于自注意力机制,实现了并行计算,大大提高了训练效率。

1.1 核心组件

- 编码器(Encoder):负责将输入序列映射到一系列连续的隐藏状态。

- 解码器(Decoder):根据编码器的输出和已生成的序列,逐步生成目标序列。

1.2 自注意力机制

自注意力机制是Transformer的核心,它允许模型在处理每个位置时,能够关注到输入序列中的所有位置,从而捕捉到序列内部的依赖关系。自注意力通过三个关键步骤实现:查询(Query)、键(Key)、值(Value)的计算,以及缩放点积注意力(Scaled Dot-Product Attention)的应用。

二、Transformer架构详解

2.1 编码器结构

编码器由多个相同的层堆叠而成,每层包含两个子层:

- 多头自注意力机制(Multi-Head Attention):允许模型在不同的表示子空间里学习信息。

- 前馈神经网络(Feed Forward Neural Network):对每个位置独立进行变换,通常包含两层线性变换和一个ReLU激活函数。

2.2 解码器结构

解码器同样由多个相同的层堆叠而成,但每层包含三个子层:

- 掩码多头自注意力机制(Masked Multi-Head Attention):确保在生成序列时,只能关注到已生成的序列部分。

- 编码器-解码器多头自注意力机制(Encoder-Decoder Multi-Head Attention):使解码器能够关注到编码器的输出。

- 前馈神经网络:与编码器中的相同。

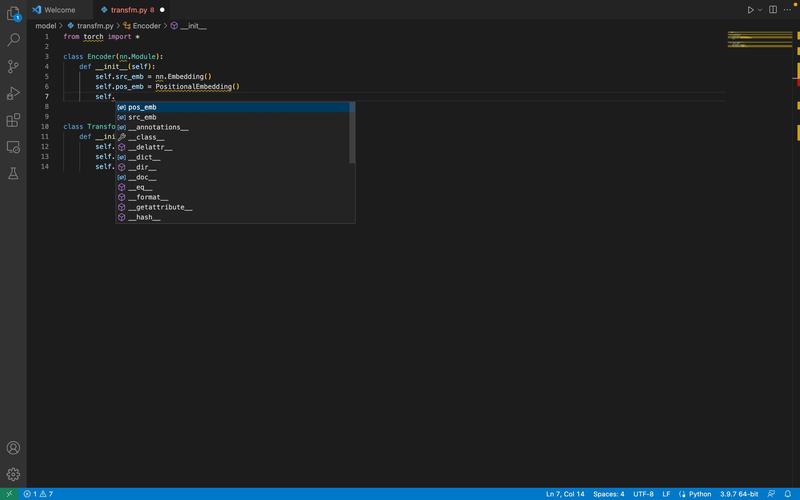

三、实战:构建一个简单的Transformer模型

接下来,我们将使用Python和PyTorch框架,动手构建一个简化版的Transformer模型。为了简化,我们将省略一些细节,如位置编码和层归一化。

3.1 导入必要的库

import torch

import torch.nn as nn

import torch.nn.functional as F3.2 定义多头自注意力机制

class MultiHeadAttention(nn.Module):

def __init__(self, embed_dim, num_heads):

super(MultiHeadAttention, self).__init__()

self.embed_dim = embed_dim

self.num_heads = num_heads

self.head_dim = embed_dim // num_heads

assert self.head_dim * num_heads == embed_dim, "Embedding dimension must be divisible by num_heads"

self.values = nn.Linear(embed_dim, embed_dim)

self.keys = nn.Linear(embed_dim, embed_dim)

self.queries = nn.Linear(embed_dim, embed_dim)

self.fc_out = nn.Linear(embed_dim, embed_dim)

def forward(self, values, keys, query, mask):

N = query.shape[0]

value_len, key_len, query_len = values.shape[1], keys.shape[1], query.shape[1]

# Split the embedding into self.num_heads different pieces

values = values.reshape(N, value_len, self.num_heads, self.head_dim)

keys = keys.reshape(N, key_len, self.num_heads, self.head_dim)

queries = query.reshape(N, query_len, self.num_heads, self.head_dim)

values = self.values(values)

keys = self.keys(keys)

queries = self.queries(queries)

energy = torch.einsum("nqhd,nkhd->nhqk", [queries, keys]) / (self.head_dim ** 0.5)

if mask is not None:

energy = energy.masked_fill(mask == 0, float("-1e20"))

attention = torch.softmax(energy, dim=3)

out = torch.einsum("nhql,nlhd->nqhd", [attention, values]).reshape(N, query_len, self.embed_dim)

out = self.fc_out(out)

return out3.3 构建Transformer模型

class TransformerModel(nn.Module):

def __init__(self, input_dim, model_dim, num_heads, num_encoder_layers, num_decoder_layers, forward_expansion):

super(TransformerModel, self).__init__()

self.encoder_layer = nn.TransformerEncoderLayer(model_dim, num_heads)

self.decoder_layer = nn.TransformerDecoderLayer(model_dim, num_heads)

self.transformer_encoder = nn.TransformerEncoder(self.encoder_layer, num_layers=num_encoder_layers)

self.transformer_decoder = nn.TransformerDecoder(self.decoder_layer, num_layers=num_decoder_layers)

self.model_dim = model_dim

self.embedding = nn.Embedding(input_dim, model_dim)

self.fc_out = nn.Linear(model_dim, input_dim)

self.pos_encoder = nn.Embedding(5000, model_dim)

self.forward_expansion = forward_expansion

def forward(self, src, tgt, src_mask, tgt_mask):

src = self.embedding(src) * math.sqrt(self.model_dim)

tgt = self.embedding(tgt) * math.sqrt(self.model_dim)

src = src + self.pos_encoder(torch.arange(0, src.shape[1], device=src.device)).unsqueeze(0)

tgt = tgt + self.pos_encoder(torch.arange(0, tgt.shape[1], device=tgt.device)).unsqueeze(0)

encoder_output = self.transformer_encoder(src, src_key_padding_mask=src_mask)

decoder_output = self.transformer_decoder(tgt, encoder_output, tgt_mask=tgt_mask, src_key_padding_mask=src_mask)

decoder_output = decoder_output.transpose(0, 1)

decoder_output = self.fc_out(decoder_output)

return decoder_output四、总结与展望

通过本文的详细解析与实战演练,相信你对Transformer模型有了更深入的理解。Transformer不仅在自然语言处理领域大放异彩,还在计算机视觉、音频处理等多个领域展现出巨大的潜力。未来,随着技术的不断进步,Transformer及其变种模型将继续推动人工智能的发展,开启更多可能性。

Transformer的提出,标志着深度学习领域的一次重大突破,它不仅革新了自然语言处理的方法论,也为其他领域的研究提供了新的思路。

希望本文能为你揭开Transformer的神秘面纱,激发你对这一领域的探索热情。