引言

随着人工智能技术的飞速发展,预训练语言模型(Pre-trained Language Models, PLMs)在自然语言处理(NLP)领域的应用日益广泛。其中,LLaMa和Qwen作为两大备受瞩目的预训练语言模型,各自拥有独特的特点和优势。本文将详细解析LLaMa和Qwen在模型规模、训练数据、应用领域、性能表现以及自我改进推理能力等方面的区别,帮助读者更好地理解这两个模型。

模型规模与参数

LLaMa(Large Language Model Family)是由Meta AI(前身为Facebook)发布的大型预训练语言模型家族,涵盖了从7B到65B参数规模的多个模型。这种多样化的模型规模使得LLaMa能够适应不同的硬件资源和计算需求,为研究者和开发者提供了更多的选择。

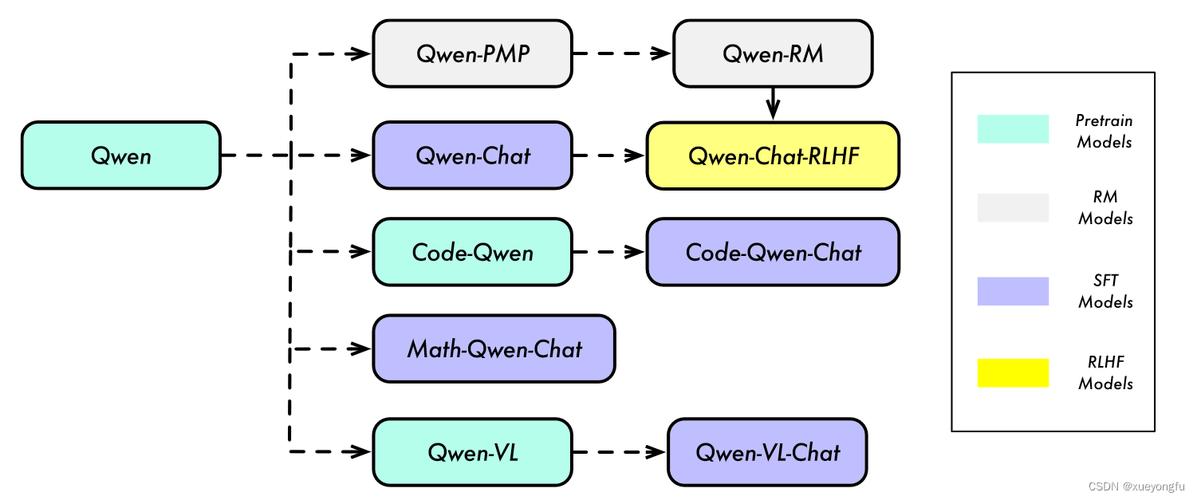

相比之下,Qwen是由阿里巴巴达摩院推出的大语言模型,虽然其具体参数规模尚未全面公开,但已知的是Qwen模型包括多个版本,如Qwen2.5-7B、Qwen2.5-14B等,部分版本如Qwen2.5-7B和Qwen2.5-14B是开源的,而Qwen2.5-Max则是闭源的。Qwen的设计也注重模型的灵活性和可扩展性,以适应不同的应用场景。

训练数据来源

LLaMa的训练数据主要来源于公共领域的文本数据,包括网页、书籍、文章等,这些数据为LLaMa提供了丰富的语言知识和上下文信息,使其能够处理多种自然语言处理任务。

Qwen的训练数据同样来源于公开领域的文本数据,但具体来源尚未全面公开。不过,Qwen特别针对中文和全球市场进行了优化,支持多种语言和多模态任务,使其在中文语境下的自然语言处理任务中表现出色。

应用领域

LLaMa作为一个大型预训练语言模型家族,可以应用于多种自然语言处理任务,如文本生成、文本分类、语义理解、自然语言翻译、文本摘要等。其广泛的应用领域使得LLaMa成为学术研究和开源开发项目的热门选择。

Qwen则更侧重于与企业需求相关的应用场景,特别是在中文和电商领域有更强的实用性。Qwen的多模态支持使其能够处理文本、图像等多种数据类型,为用户提供更加丰富和个性化的交互体验。此外,Qwen还支持根据特定数据集进行微调,以适应不同的任务需求。

性能表现

LLaMa凭借其庞大的模型规模和丰富的训练数据,展现出了强大的文本生成和语义理解能力。在多个自然语言处理任务中,LLaMa都取得了优异的表现,赢得了学术界和工业界的广泛认可。

Qwen在多个基准测试中也表现出色,其性能优于一些同类模型。特别是在中文语境下的自然语言处理任务中,Qwen凭借其针对中文的优化和多模态支持,展现出了独特的优势。此外,Qwen的长文本处理能力也显著超越了其他同类模型,支持长达100万Tokens的上下文长度。

自我改进推理能力

斯坦福大学的研究揭示了Qwen与LLaMa在自我改进推理能力上的差异。Qwen表现出风格多样的结果,能够根据用户的偏好和需求定制化输出结果,如真实画风的大象或玩具象等多样化的图像创作。这种多样化的输出不仅丰富了用户体验,也展示了Qwen强大的创造力和表现力。

相比之下,LLaMa更注重保持输出结果的一致性和稳定性。其稳健的架构设计和高效的参数调整算法确保了每次输出都能达到较高的准确率和一致性水平。这种特性使得LLaMa在处理重复性任务时表现出色,为用户提供了可靠和稳定的服务体验。

结论

综上所述,LLaMa和Qwen作为两大预训练语言模型,在模型规模、训练数据、应用领域、性能表现以及自我改进推理能力等方面都展现出各自的特点和优势。在实际应用中,我们可以根据具体需求和场景选择合适的模型,以实现最佳的自然语言处理效果。随着技术的不断进步和发展,相信这些预训练语言模型将在未来发挥更加重要的作用。